#43: Lies, damned lies, and benchmarks

Suma Positiva es una publicación semanal sobre startups, tecnología, innovación e inversión escrita por @samuelgil, Partner en JME Ventures.

Uno de los artículos más compartidos y alabados por la comunidad inversora y emprendedora esta semana ha sido el siguiente:

El artículo ha tenido tanto éxito que ha llevado a la newsletter de Lenny al top 25 de Substack por generación de ingresos. Not bad!

El artículo es verdaderamente interesante. Como decíamos, ofrece un benchmark de cuál es la tasa de retención (de usuarios a 6 meses y de ingresos netos a 12 meses) que se considera buena o excelente para los principales modelos de negocio: consumer social, consumer transactional, consumer SaaS, SMB / Mid-Market SaaS y Enterprise SaaS. En su elaboración han participado verdaderos pesos pesados de la inversión y la operación.

Os invito a que entréis a leer el artículo y el hilo. Os espero aquí.

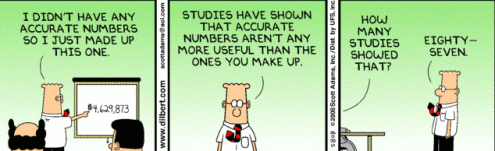

Más allá de estar de acuerdo o no con algunos de los datos presentados—en mi humilde opinión algunos de ellos poco realistas o incoherentes—, me gustaría compartir con vosotros algunos de los problemas que los benchmarks pueden—y de hecho, suelen—presentar:

Opacidad de los datos con los que están elaborados. En este caso, el estudio se supone que está basado en datos de compañías reales en las que los expertos están directamente involucrados. Pero, como es lógico por otra parte, no se nos muestran dichos datos. Y yo, que ya voy siento perro viejo, tomo aquí un poco la postura de Winston Churchill: sólo me creo ya las estadísticas que manipulo yo mismo. Honestamente, me da la sensación de que mezcla un poco datos y un poco de opinión.

No tienen validez estadística. Muy relacionado con el punto anterior. Como no sabemos cuáles son los datos en los que se basan, no sabemos si conforman una muestra suficientemente grande como para tener validez estadística. Tampoco nos permiten determinar apropiadamente qué significa ser bueno, malo, regular o extraordinario. ¿Qué percentiles equivalen a lo que ellos llaman “bueno” o “excelente”? ¿Están mezclando outliers con baseline?

No hay definiciones precisas de las métricas que se presentan, con lo cual, muchas veces se acaban comparando “peras con manzanas”. Por suerte o por desgracia, no hay definiciones universalmente aceptadas sobre cosas tan básicas como qué es un usuario activo o cómo se mide la retención. Ligeras variaciones en estas definiciones pueden llevar a valores numéricos muy diferentes.

Nos invitan a fijarnos en una única métrica cuando lo importante es el conjunto. Aún suponiendo que no hubiese el problema descrito en el punto anterior, ¿tiene sentido mirar la retención—o cualquier otra métrica—de manera aislada? Como hemos mencionado repetidamente, los elementos constituyentes de las economías unitarias son varios y además suelen operar en direcciones opuestas. La mejora de uno de ellos suele suponer el empeoramiento de otro, con lo cual el efecto en el conjunto es incierto.

En mi opinión, las consecuencias de emplear mal un benchmark—o de emplear un mal benchmark—pueden ser graves:

Algunos inversores—incluso gente experimentada de fondos top—puede llegar a no invertir en una compañía porque ésta no llega a un benchmark que se ha puesto de moda, esté bien confeccionado o no, sea del todo aplicable a la compañía o no, tenga sentido mirarlo de forma aislada o no.

Muchos operadores pueden desanimarse por estar demasiado lejos de lo que en algún parámetro del negocio se considere óptimo, a pesar de que en su caso puede que no tenga sentido por falta de comparabilidad. O puede que se centren en donde no deban centrarse, por motivos similares.

Aquí un par de reflexiones que me han parecido interesantes:

Con esto no quiero decir que los benchmarks no sean útiles. Lo son. Yo soy el primero que los tiene en la cabeza y que los utiliza continuamente. Pero no son la panacea. Hay que ser cauteloso en su uso. Sucede un poco como los múltiplos a la hora de valorar compañías. Son una chapuza, pero como todo el mundo los usa, hay que conocerlos y, en su caso, si se puede, usarlos a nuestro favor.

En un mundo en el que los datos escasean y en el que la incertidumbre es máxima, tenemos una gran necesidad de que alguien—más si es alguien supuestamente experto—nos diga de manera clara y sencilla qué está bien y qué está mal. Ansiamos por encima de cualquier otra cosa que nos reafirmen sobre si vamos por el buen camino.

Sin embargo, me temo que ningún benchmark puede sustituir al pensamiento independiente y a la comprensión fundamental de los negocios que analizamos u operamos. Recordemos una vez más que nuestros datos en combinación con nuestra estrategia, nuestra visión, y nuestro propósito es lo que debería guiarnos siempre a través de la jungla.

Buena semana,

Samuel

Otras lecturas interesantes:

What Is Good Retention: An Exhaustive Benchmark Study with Lenny Rachitsky

A Cheatsheet on Scaling (and Fundraising for) Your SaaS Startup

Mental models to analyze technology, business, and product strategy

sin duda, hay que tener mucho cuidado con los datos que se manejan y saber interpretarlos adecuadamente. Con el objetivo de no perderse en el bosque de información, una de las claves es, como bien comenta Samuel, tener un visión estratégica - 360 para evitar obsesionarnos con una sola métrica/ análisis.