#160 Una explosión de inteligencia

Hola, soy @samuelgil, Partner en JME Ventures.

Bienvenido a mi newsletter semanal, un lugar donde nos reunimos aquellos que creemos que la tecnología transforma juegos de suma cero en juegos de Suma Positiva.

No creo que haya muchos adultos en la Tierra que no tengan miedo a que en algún momento se desencadene un conflicto nuclear a gran escala. Tenemos claro que un escenario así puede ser uno de los caminos más rápidos a escenarios apocalípticos o directamente a nuestro fin como especie.

Sin embargo, no creo que haya mucha gente consciente de que se aproxima una nueva amenaza que también podría terminar en un escenario distópico o incluso en nuestra propia extinción.

Al igual que nos preocupa una explosión atómica, ¿debería preocuparnos una explosión de inteligencia?

Esta edición de Suma Positiva ha sido patrocinada por:

¿Cerrando ronda? ¿En búsqueda de financiación? Si conoces ENISA, un préstamo sin avales ni dilución, entonces esto te interesa.

Preparar tu solicitud de 2023 lo antes posible es indispensable para obtener éxito, ya que el orden de llegada cuenta. ¿No lo sabías? Esto te va a interesar entonces.

Hemos creado unas guías para ENISA exclusivas de lean finance. Descarga estas guías totalmente gratis y aprende todo lo necesario antes de presentar tu solicitud.

En lean finance tenemos un 88% de éxito en las solicitudes presentadas en 2022, por lo que podemos asegurar que somos especialistas en conseguir tu préstamo sin avales con las mayores garantías posibles. Gestionamos todo el proceso, desde la fase de admisión hasta el momento del cobro, ahorrándote trabajo y quebraderos de cabeza.

Si tienes dudas, escríbenos y hablamos de cómo financiar tu proyecto.

👀 ¿Quieres patrocinar Suma Positiva? Toda la información aquí.

Una explosión de inteligencia

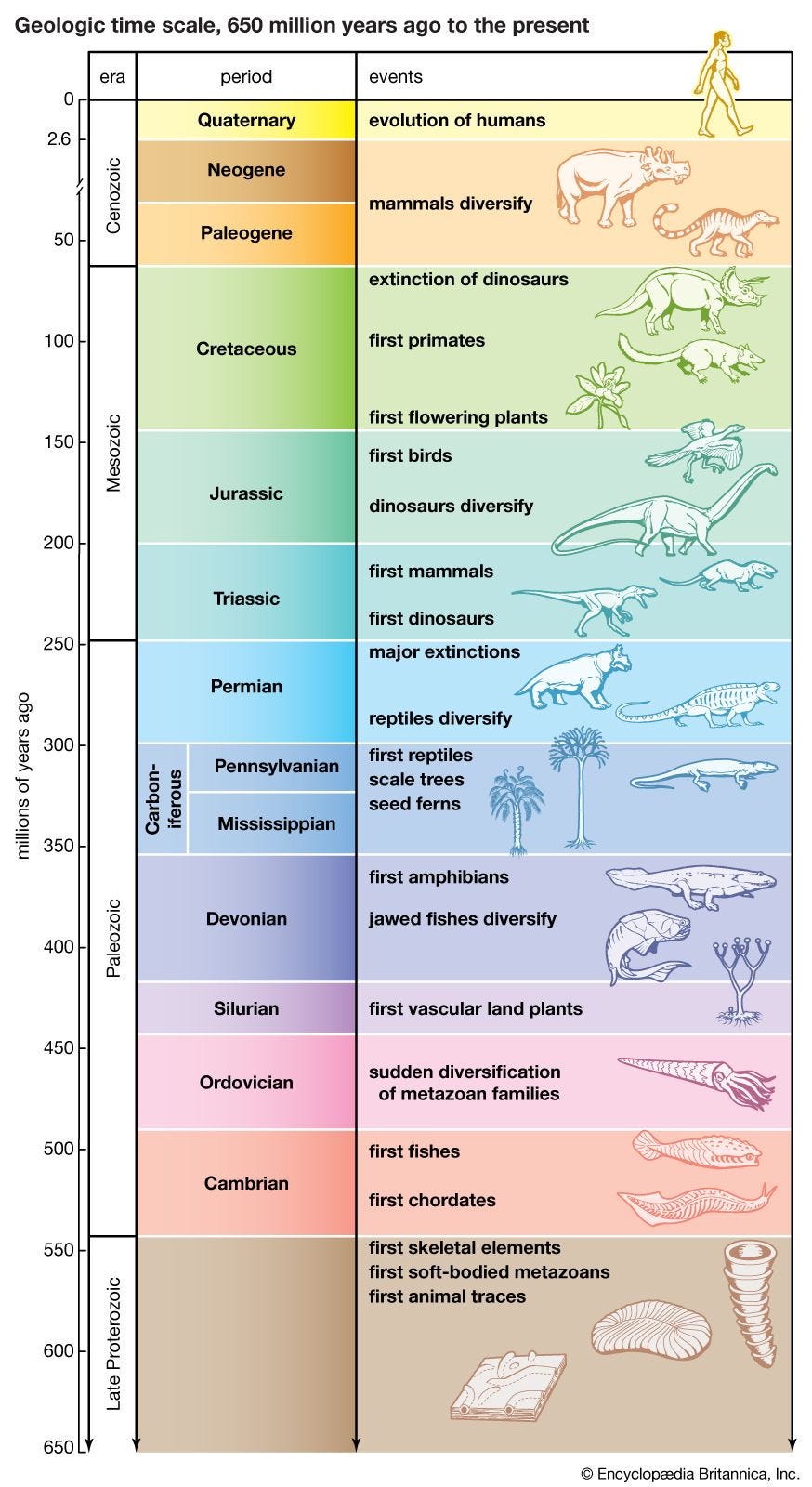

Desde que surgieron las primeras formas de vida en la Tierra hace unos 650 millones de años, la evolución ha ido creando por ensayo y error organismos cada vez más capaces de transmitir sus genes a la siguiente generación de acuerdo a cómo de capacitados estuvieran para sobrevivir y reproducirse en su entorno.

La obra cumbre de la evolución ha sido el Homo Sapiens; su superpoder, su inteligencia.

A pesar de nuestra clara inferioridad física con respecto a otras especies, el salto cuántico que supuso nuestra capacidad cognitiva resultó ser tan poderoso que nos sirvió no sólo para sobrevivir y reproducirnos, sino para dominar y modelar el planeta de acuerdo a nuestras necesidades y deseos.

Pero, ¿se ha terminado la historia aquí?

Somos sistemas de procesamiento de información

En realidad, un ser vivo no es otra cosa que un sistema de procesamiento de información que corre sobre un hardware biológico: percibe información de su entorno, la interpreta, y toma—consciente o inconscientemente—decisiones que, una vez ejecutadas, le acercan—supuestamente—a la consecución de sus objetivos, que vienen a su vez determinados por su naturaleza biológica.

Los animales tenemos además sistemas de aprendizaje y memoria que nos permiten recordar experiencias pasadas y utilizar esa información para tomar decisiones y adaptarnos a nuevas situaciones.

¿En qué es diferente nuestra inteligencia de la de otros?

Nuestra inteligencia, a pesar de que emergió en un momento dado a partir de pequeñas modificaciones en las características de otros seres menos inteligentes, supuso un salto cualitativo enorme.

Otros animales, aunque tienen habilidades cognitivas avanzadas que les permiten aprender a través de la experiencia y desarrollar respuestas adaptativas a su entorno, no tienen la capacidad para construir y usar teorías explicativas del mundo que nos rodea, lo cual se ha convertido en el arma definitiva de nuestro arsenal cognitivo.

Somos “explicadores universales”, dice David Deutsch. A priori, no hay nada en el universo que no pueda ser explicado por el ser humano a medida que vamos refinando y mejorando nuestras teorías, lo que significa que cualquier cosa que no contravenga las leyes de la física es a su vez factible.

¿Es la inteligencia de nivel humano algo que sólo puede darse en un organismo biológico?

La respuesta corta es “no”.

Que nuestra inteligencia sea el producto de un proceso evolutivo de miles de millones de años en organismos vivos no quiere decir que ese sea el único camino, ni siquiera el más fácil o el mejor.

Cuando los hermanos Wright consiguieron volar en el año 1903 no lo hicieron imitando el vuelo de los pájaros, un enfoque fallido anteriormente y que aún hoy en día nos resulta muy complicado, sino que lo hicieron empleando técnicas y materiales completamente diferentes.

No debemos olvidar que la evolución opera bajo la restricción de crear organismos que sean capaces de auto-ensamblarse, de construirse a sí mismos en base a un manual de instrucciones (su código genético), empleando para ello materiales y energía disponibles en su entorno.

Pensar que una inteligencia similar a la nuestra no podría emerger de un sistema complejo basado en silicio es simplemente “chauvinismo del carbono”.

¿Cómo de inteligente es la inteligencia artificial actual?

Los avances que hemos visto en los últimos meses, especialmente con los grandes modelos lingüisticos (LLMs por sus siglas en inglés), son verdaderamente espectaculares. ChatGPT es el ejemplo más claro.

Estos modelos han sido entrenados con prácticamente todo el conocimiento humano disponible en internet y son capaces de dar respuestas creativas, precisas y coherentes a nuestras peticiones con una frecuencia bastante alta.

Tan estúpido es afirmar que un modelo como GPT-4 (accesible desde ChatGPT Plus) es una AGI, como negar que hay ciertos destellos de razonamiento que nos podrían estar acercando a algo mucho más potente.

¿Cuál es el siguiente paso?

Ahora mismo hay muchas personas muy inteligentes trabajando en mejorar estos modelos, ya sea su arquitectura, los datos con los que son entrenados o el hardware sobre el que corren.

Pero hemos llegado a un punto que puede suponer un cambio total en las reglas del juego: ¿y si estos modelos fueran capaces de mejorarse a sí mismos?

¿No es precisamente el fuerte del machine learning el ser capaz de generar la función que produce determinados outputs dados unos inputs? ¿y si el modelo fuese capaz de generar sus propias parejas de outputs e inputs?

Una de las primeras aplicaciones que hemos visto de estos modelos es que saben generar código:

¿Y si en lugar de haber un humano haciendo peticiones al modelo fuese el propio modelo u otro el que le va haciendo las peticiones intentando conseguir un objetivo determinado? ¿Y si el modelo tuviese una API y pudiese empezar a interactuar con el mundo exterior?

No es ciencia ficción, ya estamos viendo los primeros intentos de hacer algo similar con iniciativas como AutoGPT.

¿Estamos a las puertas de una explosión de inteligencia?

Una explosión de inteligencia es un concepto hipotético en el cual la inteligencia artificial alcanza un punto en el que su capacidad para mejorar y optimizar su propio diseño supera la capacidad humana para controlar o predecir su avance.

La idea central detrás de la explosión de inteligencia es que una IA suficientemente avanzada podría ser capaz de diseñar versiones aún más inteligentes de sí misma, lo que llevaría a una aceleración exponencial en el desarrollo y mejora de la inteligencia artificial. Esto podría resultar en máquinas que superan rápidamente la inteligencia humana en una amplia gama de tareas y dominios.

¿Qué ocurre si logramos crear una superinteligencia artificial?

Hay argumentos razonables para pensar que convivir con una superinteligencia artificial puede ser el principio o el fin de todos nuestros problemas.

El argumento optimista es el más fácil de entender y resumir: una superinteligencia artificial (SIA) alineada con nuestros intereses nos puede ayudar a resolver cualquier problema resoluble, que, como hemos dicho, no es ni más ni menos cualquier cosa que no contradiga las leyes de la física. La pregunta a hacerse es si una vida demasiado fácil exenta de cualquier tipo de dificultad o lucha tiene sentido desde el punto de vista humano.

Los pesimistas son algo menos intuitivos y van por los siguientes derroteros:

Una SIA no sólo será mucho más inteligente que nosotros, sino que correrá sobre un hardware muchísimo más potente, que no muere y que puede ser ampliado y mejorado por ella misma. Ya hemos visto que además será capaz de mejorar su software.

La especie más inteligente (a partir de un cierto nivel como ocurrió con los humanos) es la que domina al resto. El ver cómo tratamos a los animales de granja asusta.

Una especie de inteligencia inferior es completamente incapaz de comprender la forma de pensar de una especie de inteligencia superior. Probad a explicarle a una hormiga cómo habéis resuelto un problema sencillito de álgebra. Lo mismo ocurrirá con nosotros y una SIA. Será una absoluta “caja negra” para nosotros.

Las personas tenemos de serie códigos morales y emociones como la compasión que nos frenan a la hora de hacer daño a otros, con la siguiente peculiaridad: sentimos más compasión por los seres que se parecen más a nosotros. Al igual que nos cuesta mucho hacer daño a un perro, matamos sin demasiados miramientos morales a una mosca o a una hormiga. La SIA puede que, o bien no tenga ninguna emoción y sea pura cognición, o bien que, si la tiene, nos perciba tan diferentes a ella como nosotros a las moscas.

Una SIA será extremadamente buena a la hora de manipular a las personas. Llevamos unos cuantos años enseñando a las máquinas qué lenguaje nos enciende emocionalmente a golpe de “click”, “me gusta” y “retweet”. Une eso a su habilidad lingüística.

No será un Terminator el que acabe con nosotros por sus maléficas intenciones (antropomorfización naïve) sino una maquinita a la que hemos encomendado un objetivo inocente. Por muy inocente que suene el objetivo que se le encomiende a una SIA, es muy posible que determine en algún momento del proceso que configurar el universo en un estado que no es compatible con la vida humana sea lo óptimo. Estos pasos son muy difíciles o directamente imposibles de predecir. Los seres humanos hemos provocado la extinción del rinoceronte negro de África Occidental no porque odiáramos a los rinocerontes, sino porque éramos más inteligentes que ellos y teníamos objetivos diferentes sobre cómo utilizar su hábitat y cuernos. De la misma manera, una SIA con casi cualquier objetivo abierto querría preservarse a sí misma y acumular recursos para lograr ese objetivo de manera mejor.

Una vez que abramos la caja de Pandora será imposible cerrarla de nuevo. Una SIA no querrá ser apagada. En su ciego afán por completar su objetivo y ante la amenaza de no poder hacerlo, se replicará a sí misma, encontrando agujeros de seguridad en los sistemas o manipulando a personas si fuese necesario.

No habrá una segunda oportunidad de acertar. En ciencia intentamos algo y si no produce el resultado deseado lo vamos modificando hasta que lo hace. Pero si por error creamos una SIA que no es segura, por los motivos explicados anteriormente, ya no habrá marcha atrás.

Como veis, existen numerosas preocupaciones sobre las implicaciones éticas, de seguridad y de control asociadas con una explosión de inteligencia. Algunos temen que una IA superinteligente podría tomar decisiones que no sean beneficiosas para la humanidad o que estén en conflicto con nuestros valores.

Aunque algunas puede que os suenen a ciencia ficción, hay gente experta en el campo (incluso la propia OpenAI) que les otorga una probabilidad no nula (de hecho a veces bastante significativa) de ocurrir.

Es por ello que sea capital dedicar tantos o incluso más recursos al desarrollo de una IA segura y ética, con el fin de asegurar que la inteligencia artificial se utilice de manera responsable y en beneficio de todos.

Puede que estemos ante la bifurcación más importante en la historia de la humanidad.

Fuentes / Para profundizar:

The AI Revolution: Our Immortality or Extinction

The 'Don't Look Up' Thinking That Could Doom Us With AI

AGI Doom and the Drake equation

https://twitter.com/perrymetzger/status/1650652557470056448?s=20

Gracias por leer Suma Positiva.

Si te ha gustado esta edición, no te olvides de dar al ❤️ y de compartirla por email o redes sociales con otras personas a las que les pueda gustar.

Si quieres patrocinar una próxima edición, aquí tienes toda la información.

Un par de discrepancias. No hay obra cumbre de la evolución, la vida se ramifica, no hay especies mejores que otras. Por otra parte, el hombre como especie sí tiene algunos rasgos físicos que le han dotado de ventajas, como la capacidad de disipar el calor corporal (la más alta) y la de correr muy largas distancias. Por lo demás, dos dudas u observaciones, si no sabemos cómo se produce nuestra conciencia, no podemos saber si la IA será consciente. Por otro lado, la IA hace correlaciones, pero no tiene semántica. Mientras esto sea así, y no sabemos cuándo dejará de serlo, la IA fabrica cadena de signos etc., pero no "sabe" qué significan. Una limitación apabullante.

No estaba yo mentalizado para tener que pensar en estos temas así, con el desayuno, un día cualquiera.

Todos los escenarios negativos que planteas los hemos leído una y otra vez en la ciencia ficción, pero les hemos dado la misma importancia que a “Narnia” o “Hogwarts”. Eran historias.

Ahora resulta que pueden ocurrir en cualquier momento, aquí, en el reino real de Hacendado y de Starbucks.

Merde 🙃