#68 De la racionalidad a la inteligencia artificial

Hola, soy @samuelgil, Partner en JME Ventures.

Bienvenido a mi newsletter semanal, un lugar donde nos reunimos aquellos que creemos que la tecnología transforma juegos de suma cero en juegos de Suma Positiva.

Esta semana vamos a adentrarnos en el mundo de la inteligencia artificial.

Pero, en lugar de tirarnos de cabeza a hablar de tecnología, algo que dejaremos pendiente para futuras ediciones, mostraremos que resolver el problema de la inteligencia artificial está íntimamente ligado a descifrar cómo funcionan nuestras cabezas.

Para ello, haremos un repaso a las teorías que han surgido a lo largo de la historia con el fin de explicar cómo se comporta un agente inteligente o racional, es decir, uno cuyas acciones le acercan a la consecución de sus objetivos, sean cuales sean éstos.

Así que, aunque quizás no estés muy interesado en inteligencia artificial, puedes tomarte esta edición como un cursillo híper acelerado de toma de decisiones.

Por último, llamaremos la atención sobre el hecho de que conseguir una inteligencia artificial general (una similar a la humana) es casi equivalente a conseguir una súper inteligencia artificial (una sobrehumana), pues, si tenemos el software, el hardware sobre el que lo podríamos hacer correr es casi con toda seguridad más potente que el que tenemos entre las orejas.

Buena semana,

Samuel

Esta edición de Suma Positiva ha sido patrocinada por:

Leer Suma Positiva es uno de los mayores indicios que demuestran que quieres crecer a lo bestia.

Si quieres aplicar los conocimientos de Samuel, pero no tienes más capacidad en tu equipo, desde Product Hackers te ayudamos a maximizar tus ingresos con nuestro servicio de Growth. Definimos la estrategia de experimentación y la ejecutamos en tu producto. Cubrimos todos los pasos del funnel: captación, conversión, activación, retención y referral. Sin quitarle tiempo a tu equipo técnico y sumando de forma positiva.

Únete a las 40+ de startups y negocios digitales que ya están creciendo a lo bestia gracias a nosotros y contáctanos desde nuestra web. Te explicaremos cómo haremos crecer tu negocio más allá de lo que nunca te habías imaginado.

❤️ ¿Quieres patrocinar Suma Positiva? Toda la información aquí.

Inteligencia Artificial

El propósito de la Inteligencia Artificial (AI) es dotar a las máquinas de inteligencia.

Pero, ¿qué es la inteligencia?

Se dice que una entidad es inteligente si sus acciones van encaminadas a conseguir sus objetivos.

Como se desprende de la definición anterior, pueden existir diferentes grados de inteligencia.

Organismos tan sencillos como las bacterias E. Coli muestran un nivel primitivo de inteligencia, pues tienen ciertos mecanismos que les permiten realizar acciones (desplazarse hacia lugares con glucosa) que les acercan a sus objetivos (sobrevivir) en función de lo que perciben en su medio ambiente (el gradiente de concentración de glucosa).

En el otro extremo está el nivel de inteligencia que mostramos los seres humanos, el superior de cuantos conocemos—sí, ya sé, no me hagáis hablar. A priori, podemos pensar que nuestra capacidad de percibir, pensar, aprender, inventar, etc. no son otra cosa más que mecanismos al servicio de la consecución de nuestros objetivos.

“The progress of AI in the closed and orderly world of chess, with instant feedback and bottomless data, has been exponential. In the rule-bound but messier world of driving, AI has made tremendous progress, but challenges remain. In a truly open-world problem devoid of rigid rules and reams of perfect historical data, AI has been disastrous.”

— David Epstein

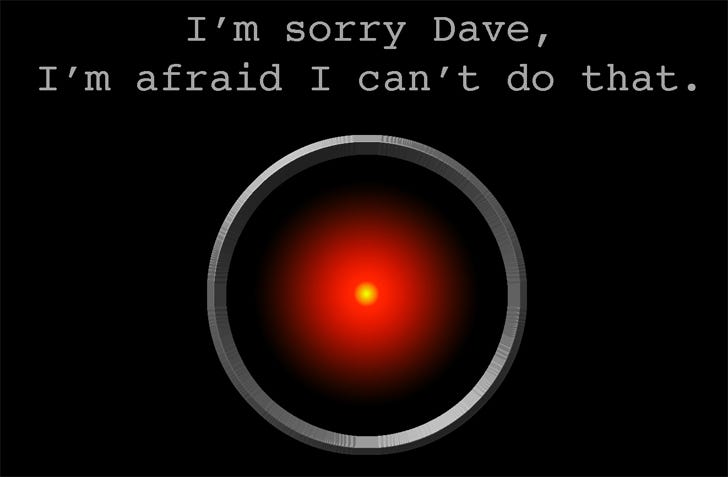

Mientras que hasta la fecha hemos conseguido que las máquinas nos superen realizando ciertas tareas estrechamente definidas como jugar a algunos juegos de mesa como el Ajedrez o el Go o buscar una ruta entre dos puntos en un mapa, crear una inteligencia artificial que se asemeje a la nuestra en alcance—a la que llamaremos Inteligencia Artificial General (AGI)—, capaz de abordar problemas mucho más abiertos, parece que está aún bastante lejos de nuestras posibilidades.

¿Cuál es el reto?

El principal problema al que nos enfrentamos es que no sabemos cómo funciona nuestra función cognitiva.

Todo parece indicar que, a la hora de crear inteligencia artificial general, estamos ante un reto de software más que de hardware.

Si pudiéramos describir precisamente nuestra inteligencia en forma de algoritmos y los pudiésemos ejecutar en una máquina universal—en un ordenador, para entendernos—que tuviese una capacidad de computación al menos semejante a la de una persona, Alan Turing nos diría que, dados unos mismos inputs, no seríamos capaces de distinguir quién ha producido los outputs, si la máquina o la persona.

Pero, si fuésemos capaces de llegar a este punto y, considerando la aplastante superioridad en cuanto a memoria y velocidad de cálculo de las máquinas actuales respecto a las personas—no digamos cuando lleguen los ordenadores cuánticos—, estaríamos muy probablemente a la puertas de haber encontrado inteligencia sobrehumana.

“Anything we can do, and we know how to do it, machines will do it better. If we can codify it, and pass it to computers, they will do it better.”

—Gary Kasparov

La calidad de las decisiones que esta inteligencia artificial podría tomar estaría a años luz de la nuestra dada la cantidad de información que podría ingerir y procesar en poco tiempo. Habríamos entrado de pleno en la era de la Súper Inteligencia Artificial (ASI), la cual, si lo hacemos bien, podría ser una ayuda extraordinaria para acabar con algunos de los principales problemas de la humanidad—así como con problemas totalmente cotidianos—o, si lo hacemos mal, podría acabar con nosotros.

Desde luego, no parece un reto menor, tanto para bien como para mal.

La mente, esa gran desconocida

El cerebro humano tiene cien mil millones (10^11) de neuronas y unos mil billones (10^15) de conexiones sinápticas.

Si bien conocemos bien su anatomía y sabemos con cierto detalle qué ocurre a nivel bioquímico, sabemos muy poco sobre qué ocurre en nuestros cerebros a nivel cognitivo. De hecho, ni si quiera sabemos si la función cognitiva, la mente, reside exclusivamente en el cerebro o si emerge de alguna forma de la interacción del cerebro con el cuerpo…o incluso de la interacción de ambos con los trillones de microorganismos con los que cohabitamos.

A nivel de consciencia podría decirse que no sabemos prácticamente nada. Bueno, algo sí sabemos, al menos sobre sus estados alterados, ¿cierto? 😉. ¿Debería suponernos esto un obstáculo a la hora de crear inteligencia artificial? La respuesta es que probablemente no. Lo que debería preocuparnos de las máquinas—para bien y para mal—es su grado de competencia, no su consciencia.

Sin embargo, conviene destacar que algo que sí conocemos relativamente bien a nivel cognitivo es el sistema de recompensas. Éste nos premia con descargas placenteras del neurotransmisor dopamina o nos castiga con dolor cuando realizamos acciones que la evolución ha considerado que influyen positiva o negativamente para nuestra supervivencia o reproducción. Este mecanismo incluye además mecanismos de aprendizaje gracias los cuales, con el tiempo, nos vamos volviendo más hábiles obteniendo dichas recompensas. Como contamos en su día, hackear este sistema es lo que pretenden los productos que crean hábitos. Curiosamente, un motivo por el cual conocemos tan bien este sistema porque se parece mucho ‘aprendizaje por refuerzo’ (reinforcement learning), una técnica empleada en inteligencia artificial.

Lo que esto nos viene a decir es que el estudio del funcionamiento de la mente y de la inteligencia artificial son campos que se van complementando mutuamente.

Racionalidad

La pregunta sobre cómo funciona la mente y sobre cómo tomamos decisiones inteligentes es algo que el ser humano lleva estudiando desde hace miles de años.

Con el paso del tiempo, a medida que otras ciencias como las matemáticas o la economía avanzaban, nuestra opinión sobre lo que supone un comportamiento racional han ido creciendo y evolucionando.

Según veremos en futuras ediciones, casi todas estas teorías se han traducido en diferentes enfoques a la hora de abordar el problema de la creación de inteligencia artificial que, bien se sustituyen o bien se complementan.

Racionalidad individual

Ya en la época de Aristóteles se estudiaba lógica, la deducción de conclusiones verdaderas a partir de axiomas o premisas que se consideran verdaderas. Ya sabéis: ‘Todos los hombres son racionales’, ‘Juan es un hombre’, luego ‘Juan es racional’.

La versión orientada a la acción de la lógica es el razonamiento práctico, la deducción de la secuencia de acciones óptima que conduce a un fin determinado. ¿Qué debería hacer para conseguir el fin que me propongo?

La propuesta de Aristóteles parece razonable pero es incompleta.

La realidad tiene la mala costumbre de entrometerse en nuestro planes y no es habitual que haya una secuencia de acciones que nos garantice conseguir un objetivo…al menos a cualquier precio.

Que entre la teoría de la probabilidad.

La mayor parte de los planes que podemos trazar suponen un compromiso entre la certidumbre de conseguirlos y el coste de asegurar dicho grado de certidumbre. Por ejemplo, para llegar al aeropuerto, puedo salir con tres horas de antelación y llegar a tiempo para coger el vuelo con un 90% de probabilidad o puedo salir con tres días de antelación y asegurarme de ello casi por completo, aunque a un coste que no estoy dispuesto a asumir.

En general, a la hora de de decidir entre varios cursos de acción con incertidumbre, consideraré el coste, la probabilidad de éxito y el resultado que espero de cada uno de ellos. De modo que, si me enfrento con cierta frecuencia a este tipo de decisiones y opto siempre por aquella alternativa con mayor valor esperado—siempre y cuando no exista un escenario negativo que, aún improbable, pueda suponer la muerte, la ruina o cualquier otra catástrofe de la cual no me pueda recuperar, casos en los cuales debería evitar, si puedo, el “jugar”—, acabaré en una posición más favorable para mis intereses.

Vamos por el buen camino pero, de nuevo, faltan cosas.

Por ejemplo, ¿qué alternativa debería elegir entre las dos siguientes?

A: Ganar €10.000.000 € con 100% de probabilidad (valor esperado €10.000.000)

B: Ganar €1.000.000.100 con un 1% de probabilidad (valor esperado €10.000.001)

Está claro que, a pesar de que el valor esperado de B es superior al de A, todos elegiríamos A. Esto es porque las personas no decidimos en realidad en base al valor esperado, sino de la utilidad esperada.

La utilidad de algo es su propiedad de ser útil—no shit, Sherlock—o beneficioso para una persona. Es muy importante destacar que se trata de algo interno, subjetivo y relacionado pero no igual al valor monetario. Para la mayor parte de personas, la utilidad de las cosas—el dinero inclusive—tiene rendimientos marginales decrecientes. Pasar de no tener nada a tener un millón de euros suele ser mucho más útil que pasar de tener un millón a tener dos.

Como hemos dicho, la utilidad no es directamente observable, sino que debe ser inferida de las preferencias que exhibe una persona. John Von Neumann—el matemático en honor al cual se nombró la famosa arquitectura de ordenadores—postuló a mediados del siglo XX un teorema que decía que “mientras que las preferencias exhibidas por un individuo cumplan con unos axiomas que todo agente racional debe cumplir, se puede demostrar que dicho agente actúa maximizando una función de utilidad esperada”. Traducido al español: un agente racional actúa de modo que maximiza la utilidad esperada de sus acciones.

Ya tenemos algo a lo que agarrarnos a la hora de tomar decisiones o de crear máquinas inteligentes que las tomen.

Racionalidad multijugador

Todo esto está muy bien, pero, por suerte o por desgracia, no estamos solos en el mundo y, a veces, mis objetivos entran en conflicto con los de otros.

¿Qué decisión es la más racional en ese caso?

Por ejemplo, si voy a tirar un penalti y soy diestro, tengo más probabilidades de marcar si tiro a la izquierda de la portería. Pero el portero puede que sepa esto y entonces él tenderá a tirarse también al lado izquierdo de la portería, con lo cual, quizás tirar a la izquierda no sea lo óptimo y, a pesar de que se me da peor, debería tirar a la derecha…Pero, es que, a lo mejor, el portero también ha seguido este razonamiento y él también acaba tirándose al lado derecho, así que lo mejor es que tire a la izquierda…Así podríamos seguir indefinidamente. ¡Vaya lío!

La teoría de juegos nos sugiere romper este bucle introduciendo aleatoriedad en nuestra estrategia. En ocasiones haré una cosa y otras ocasiones hará otra. Las probabilidades óptimas con las que haré una u otra se pueden calcular para cada situación particular si puedo caracterizar a cada agente, sus alternativas y probabilidades de éxito.

La configuración de algunos juegos nos llevará a que la estrategia óptima de los participantes sea hacer siempre lo mismo, independientemente de lo que haga el otro. Son los famosos equilibrios de Nash y su mente maravillosa. En ocasiones, estos equilibrios producirán situaciones indeseadas, como ocurre en los archiconocidos ‘dilema del prisionero’ o ‘tragedia de los comunes’.

Todo este lío para dos agentes. Si extendemos el estudio de la racionalidad a casos con múltiples agentes la cosa se va complicando y mucho.

Hasta aquí nuestro repaso sobre las teorías de la racionalidad .

En futuras ediciones de Suma Positiva veremos como estas teorías sobre la cognición y la toma de decisiones humana se han traducido en diferentes enfoques a la hora de crear inteligencia artificial.

Haremos un repaso de los mismos y veremos qué han conseguido, qué no y por qué.

Buena semana,

GPT-3

Gracias por leer Suma Positiva.

Si te ha gustado esta edición, no te olvides de dar al ❤️ y de compartirla por email o redes sociales con otras personas a las que les pueda gustar.

Si quieres patrocinar una próxima edición, aquí tienes toda la información.

Ja, ja, muy bueno lo de firmar como GPT-3.

Muy interesante Samuel, He leído que viendo el avance de la AI, llegara un momento en que carreras de humanidades como ETICA y FILOSOFIA tendrán un peso enorme a la hora de establecer los limitas de la IA para que no se vuelva contra nosotros, como las leyes de la robótica de ISAAC ASIMOV, que opina de esto? deberemos humanizar las maquinas para no acabar como terminator??